Archivo

¿Cual es el PUE recomendable en España?

El PUE se ha transformado en la medida principal de la eficiencia de los Datacenters. La formula para calcularlo es:

y básicamente mide la diferencia entre el consumo total de electricidad y el que se destina a alimentar el equipamiento IT. No hay que olvidar que actualmente el consumo de la infraestructura necesaria para operar el DC (Clima principalmente), supone entre el 28 y el 30% del consumo de un Datacenter.

y básicamente mide la diferencia entre el consumo total de electricidad y el que se destina a alimentar el equipamiento IT. No hay que olvidar que actualmente el consumo de la infraestructura necesaria para operar el DC (Clima principalmente), supone entre el 28 y el 30% del consumo de un Datacenter.

¿Cuál es el PUE medio en España?

Es difícil de saber, principalmente porque no todos los operadores hacen disponible esta información.

¿Cuál es el PUE recomendable para España?

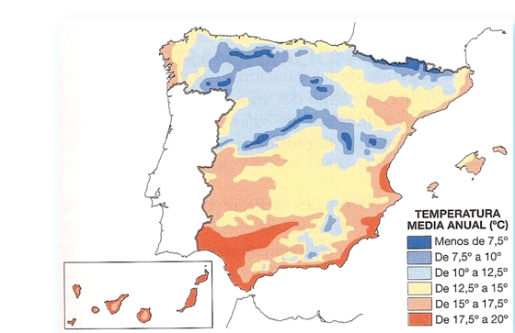

Nuevamente es difícil de decir, puesto que esto dependerá fundamentalmente de en qué zona geográfica esta ubicada nuestra instalación.

Los chicos de ASHRAE que no pueden perder oportunidad de hacer recomendaciones, van a preparar un nuevo documento donde indicaran en función de la zona en la que este ubicada nuestro CPD, cual es el PUE objetivo.

| Power Usage Effectiveness (Design PUE) Maximum | |

|---|---|

| Climate Zone | Design PUE |

| 1A | 1.61 |

| 2A | 1.49 |

| 3A | 1.41 |

| 4A | 1.36 |

| 5A | 1.36 |

| 6A | 1.34 |

| 1B | 1.53 |

| 2B | 1.45 |

| 3B | 1.42 |

| 4B | 1.38 |

| 5B | 1.33 |

| 6B | 1.33 |

| 3C | 1.39 |

| 4C | 1.38 |

| 5C | 1.36 |

| 7 | 1.32 |

| 8 | 1.30 |

¿Cómo queda el reparto de zonas?

concretamente y para el caso de España

lo que nos daría un PUE medio de entre 1.36 y 1.41.

Para que os hagáis una idea de lo importante de la ubicación del Datacenter, más el uso de las últimas técnicas os dejo un ejemplo de PUE de uno de los Datacenters de Facebook.

<fuente aquí>

¿Puedo bajar la humedad de mi Datacenter?

La humedad relativa en el Datacenter es una de esas grandes desconocidas, quizás no para todos, pero si para muchos managers que desconocen el impacto y efecto de bajarla o subirla en nuestro Datacenter.

¿Cuál es la humedad relativa recomendada?

Normalmente se dice que la HR debe estar entre el 40 y el 55%, ¿por qué?, por encima del 55% aumentaríamos el riesgo de corrosión, y por debajo del 40% aumentamos el riesgo de descargas estáticas.

¿Podemos infringir estos valores?

Por supuesto que podemos, tan solo necesitaremos modificar el setup de nuestras máquinas de clima ;-). Bromas aparte, al igual que con las franjas de temperatura de operación, cada vez hay más managers (incluso la propia ASHRAE) que abogan, por aprovechar la mayor robustez del equipamiento IT, para aumentar el rango de HR permitido.

¿Qué ventajas aportaría modificar el rango permitido de HR?

Fundamentalmente una, el ahorro energético. Ashrae va a publicar un Whitepaper destinado a los grandes operadores de Datacenters acerca de este tema. En dicho Whitepaper se indica que hoy por hoy es seguro permitir que la HR baje hasta alrededor de un 8%. Esta indicación se basa en estudios donde comprobaron que la diferencia de electricidad estática es muy pequeña entre el 8% y el 25%.

No hay que olvidar además que la temperatura y la humedad estan relacionadas, por lo que aumentar estos rangos puede reportar un importante ahorro.

DC en el Datacenter, ¿el futuro?

Hace poco he tenido oportunidad de participar en una charla/debate acerca del sentido o no de usar DC (corriente continua) para alimentar a los servidores en el DataCenter y me ha servido de motivación para escribir este post.

Los que me conocéis o seguís, sabéis que la arquitectura de Sistemas y la explotación de grandes infraestructuras es un tema que me interesa sobremanera, además he tenido la suerte de profesionalmente estar vinculado, bien en proyectos para ellas o directamente como responsable de las mismas.

¿Como es un Datacenter tradicional?

En un Datacenter tradicional, la entrada o suministro de energía se realiza en corriente alterna (por simplicidad vamos a dejar de lado conceptos como baja, media o alta tensión que serían complicar innecesariamente el artículo), después esa corriente alterna se transforma en corriente continua, que es la que pueden almacenar los SAIs, para después volver a convertirse de continua a alterna para alimentar a los servidores. Esto que parece un follón, no termina aquí, pues aún restaría otra conversión de alterna a continua que realizarán las fuentes de alimentación de los servidores para alimentar las componentes internas del propio servidor.

En total se realizan las siguientes conversiones AC=>CC (DC) =>CA=>CC(DC),

lo que supone al menos 3 conversiones cada una de ellas con su correspondiente perdida en la transformación (dependerá de lo eficientes que sean nuestros equipos). Fijaos que fuente de ineficiencia más grande, 3 conversiones para llegar a la finalidad última que es alimentar el dispositivo IT.

lo que supone al menos 3 conversiones cada una de ellas con su correspondiente perdida en la transformación (dependerá de lo eficientes que sean nuestros equipos). Fijaos que fuente de ineficiencia más grande, 3 conversiones para llegar a la finalidad última que es alimentar el dispositivo IT.

¿Hay otra manera de hacer las cosas?

Por supuesto, con el presupuesto suficiente y los profesionales adecuados siempre la hay ;-).

En grandes Datacenters sobre todo, se estudiando y probando la manera de reducir el nº de transformaciones necesarias desde distinta óptica.

Algunos ejemplos posible serían:

- Google: Prescinden de la UPS clásica en la entrada o acometida y traslada esta funcionalidad a los servidores, es decir son los servidores los que tienen una pequeña batería que haría las veces de UPS, de esta maneras se convierte de alterna a continua una única vez (en la fuente del servidor)

- Microsoft: utiliza un enfoque parecido a Google, pero ellos realizan la transformación a continua en la acometida del Rack, situando la batería antes de la alimentación al servidor.

- Facebook: Son los más creativos sin duda y los que más avanzados (en mi opinión) están en este aspecto. Se van notando además las distintas mejoras fruto del proyecto OpenCompute

<original de la imagen aquí>

<original de la imagen aquí>

¿Tiene sentido esta discusión en el contexto actual español?

Como todo, dependerá de la organización.

En mi experiencia la mayoría de organizaciones aún tienen camino por recorrer en términos de mejora de eficiencia a través de conceptos de diseño de Datacenters mucho más sencillos (puedes leer algunos aquí), o a través de mejoras en la arquitectura de sistemas (Consolidación de servidores a través de la virtualización, Hyperconvergencia, SDN,etc, etc.).

Una organización que aún no conoce sus costes de operación en el Datacenter, que aún no aplica los consejos de ASHRAE, que no mide donde y como se consume la energía difícilmente tendrá la madurez para abordar un proyecto de este tipo y si lo aborda seguramente nunca llegue a saber si el resultado es el adecuado o cuanto se ha mejorado.

y vosotros, ¿qué opináis?

Free Cooling for dummies

Continuando una de las sagas de artículos que más éxito tiene en este blog, «Tecnología for dummies», voy a tratar de explicar que es el Free Cooling y cuáles son las principales maneras de implementarlo. Para los puristas y expertos con muchos Data Centers diseñados y operados en sus espaldas, indicarles que este no es su artículo ;-).

¿Qué es eso del Free Cooling?

Bien, es una expresión que viene del inglés y que viene a significar algo así como, refrigeración sin coste o gratis, ¿gratis?, ¿es esto posible?…… NO, al final todo tiene coste, pero sí que puede ser mucho más económica que la refrigeración tradicional.

El concepto base es muy sencillo, si fuera de nuestro Data Center (en el exterior), tenemos una temperatura suficientemente baja, podemos usar el «frio» exterior para eliminar el calor generado en nuestro Data Center.

¿Y cómo lo hacemos?

Hay dos grandes vertientes para hacer esto (cada una de ellas puede tener, n matices), de manera directa y de manera indirecta.

Directa: Es la más sencilla. Si fuera tenemos aire frio, cojo ese aire frio y lo introduzco directamente en el Data Center para bajar la temperatura. Haciendo un símil un tanto burdo, abrimos las ventanas para que entre el fresquito.

<imagen cortesía de stultz.com>

<imagen cortesía de stultz.com>

Efectivamente no es tan sencillo ya que el aire exterior requiere ser filtrado para eliminar suciedad y sobre todo adecuado en temperatura y humedad. No podemos introducir aire con una gran humedad ni tampoco demasiado frio, ¿os imagináis vuestro Data Center a -3ºC?. Este acondicionamiento del aire se logra mediante filtros, cámaras/zonas de atemperamiento y otros métodos.

Indirecta: Para evitar los problemas de introducir el aire frio directamente, usamos algún otro método para intercambiar el calor de dentro con el frio de fuera. Nuevamente y haciendo una simplificación imprecisa, nuestro Data Center es un circuito cerrado, donde el mismo aire se calienta por los servidores y enfría (de manera indirecta).

<imagen cortesía de stultz.com>

<imagen cortesía de stultz.com>

¿y esto tiene sentido en España?

En el artículo «¿Es el Free Cooling una opción viable para España?«, podéis encontrar algo más de información al respecto. Como es de suponer hay zonas a priori mucho más propicias para aprovechar esta tecnología que otras (Madrid mejor que Sevilla, y el norte mejor que Madrid ;-))

Para aquellos que estéis dandole vueltas a la cabeza, efectivamente no es casualidad que los grandes Data Centers de Google o Facebook, se instalen en regiones frías, ya que el Free Cooling puede suponer un importante ahorro en uno de los aspectos de operación que mayor coste tiene. Cuanto más baja sea la temperatura media a lo largo del año, más franja de tiempo utilizable por Free Cooling tendremos.

Dentro de un Data center de Google / Inside a Google data center

De la mano de Joe Kava, (VP of Google’s Data Center Operations), os traigo un pequeño tour por uno de los Data Centers de Google

Google junto con Facebook y alguna que otra gran tecnológica más son una autentica referencia en cuanto a innovación en Data centers se refiere.

Personalmente no me canso de ver/leer información sobre sus diseños.

ASHRAE y sus recomendaciones de temperatura en el DC for dummies:

¿Qué es ASHRAE?

ASHRAE (American Society of Heating, Refrigerating and Air Conditioning Engineers) es una organización nacida en 1984 cuyo objetivo es la mejora de las condiciones de refrigeración, calidad del aire, etc. para la industria y entre sus socios se encuentran los principales fabricantes de tecnología.

Entre sus funciones se encuentran la elaboración de guías para la optimización de distintos entornos, un ejemplo de las cuales sería:

- Thermal Guidelines for Data Processing Environments

¿Qué recomendaciones da ASHARE en lo referente a la temperatura del Datacenter?

Las recomendaciones han ido variando a lolargo del tiempo y con la evolución de la tecnología, siendo a día de hoy las temperaturas recomendadas las siguientes:

- Rango de temperatura permitido de 5º a 45º centígrados

- Rango recomendadode 18º a 27º centígrados

¿Qué significa en la práctica las recomendaciones de ASHRAE?

En más de una ocasión un cliente o un lector me ha preguntado cual es la temperatura óptima de funcionamiento para un Datacenter, algunos conocían las recomendaciones de ASHRAE otros no, pero incluso entre los conocedores de ASHRAE existía una cierta duda de como aplicar sus recomendaciones.

Respecto a la temperartura óptima decir que es la temperatura más alta que estando dentro de los parámetros de operación de nuestros servidores, dipositivos de red, etc., nos permite operar el Datacenter en condiciones de seguridad. La climatización es uno de los costes de operación más altos de un Datacenter, por lo que cualquier reducción en este sentido, tiene impacto directo en nuestros costes.

Las recomendaciones de ASHRAE están avaladas por los fabricantes (no olvidemos que ellos forman parte de ASHRAE).

¿Significa esto que puedo tener mi datacenter a 27º?

Depende y aquí es donde surgen las mayores dudas. ASHRAE recomienda unas franjas de temperaturas….. pero ¿donde deben estar esas temperaturas?, en la entrada de aire al servidor.

La mayoría de los Datacenters miden la temperatura en los pasillos (frios y calientes), en un punto determinado o en varios, pero en raras ocasiones se mide dentro del rack (en la entrada al servidor). En la práctica esto significa que aunque nuestro pasillo frio este a pongamos 25º, la entrada de aire al servidor puede ser mayor debido a recirculaciones de aire dentro del rack o por su posición (a más altura el aire tendrá mayor temperatura).

También es habitual chequear la temperatura de retorno del aire a nuestro sistema de clima, nuevamente esta temperatura puede verse influenciada por recirculaciones dentro del propio Datacenter.

¿Cómo aplico las recomendaciones de ASHRAE?

Nuestro trabajo como managers de un Datacenter consistirá en lograr que la temperatura en el sea los más homogénea posible en cada una de las zonas, de manera que evitemos zonas excesivamente frias o calientes y que logremos la máxima contención de las mismas.Para lograr esta contención podemos usar separación entre pasillos, paneles ciegos dentro de los racks o sellado del suelo técnico entre otras técnicas.

Si logramos una temperatura homogénea podremos ir elevando nuestra temperatura de operación poco a poco, siempre vigilando no exceder en ningun punto de entrada a equipos las temperaturas recomendadas por ASHRAE.

y vosotros ¿a qué temperatura operáis vuestros Datacenter?

Proyecto CoolEmAll

CoolEmAll es un proyecto de la Comisión Europea cuyo objetivo es lograr que los Data Centers sean más eficientes.

Para lograr esta mejora en la eficiencia se pretende desarrollar herramientas y lograr importantes mejoras en la monitorización y simulación (otra de esas grandes desconocidas) en el Data Center.

Para lograr esta mejora en la eficiencia se pretende desarrollar herramientas y lograr importantes mejoras en la monitorización y simulación (otra de esas grandes desconocidas) en el Data Center.

Se trata de un proyecto muy interesante que esperemos arroje resultados pronto.

Podéis encontrar más información sobre el proyecto en los siguientes vídeos:

En la web del proyecto podéis encontrar no solo más vídeos, sino también el Toolkit para testeo.

Espero os resulte de utilidad.

as

Array solar del Data Center de Apple en Maiden

El uso de energías renovables en los grandes Data Centers de las principales compañías de internet se esta incrementando, hasta el punto de no concebirse una instalación de este tipo, alimentado unicamente por energías «sucias».

Si Facebook nos sorprendió hace poco con su nuevo Data Center en Suecia, Apple no quería ser menos y ha optado por un array solar de grandes dimensiones para su instalación de Maiden.

Refrigeración de Datacenters según Rittal

Os traigo un video resumen de algunas técnicas de refrigeración aplicadas a Datacenters, desarrollado por la empresa Rittal. Aunque no cubre todas las posibles técnicas al estado del arte, es bastante didáctico.

espero que os guste

La busqueda de la eficiencia energetica en cifras (Schneider Electric)

Puesto que uno de los principales costes de mantenimiento de un CPD es el suministro eléctrico, resulta interesante ver análisis sobre la intención de mejora en este aspecto, más aun si este lo realiza uno de los grandes proveedores de infraestructura para datacenters.

puedes consultar el original aquí.